我们将从零开始实现整个方法,包括数据流水线、模型、损失函数和小批量随机梯度下降优化器

import random

import torch

from d2l import torch as d2l生成数据集

根据带有噪声的线性模型构造一个人造数据集。我们使用线性模型参数 、 和噪声项 生成数据集及其标签:

def synthetic_data(w, b, num_examples):

"""生成 y = Xw + b + 噪声"""

# 生成均值为 0,方差为 1 的 num_examples * len(w) 的随机矩阵

X = torch.normal(0, 1, (num_examples, len(w)))

y = torch.matmul(X, w) + b

# 噪声

y += torch.normal(0, 0.01, y.shape)

return X, y.reshape((-1, 1)) # 变成列向量

true_w = torch.tensor([2, -3.4])

true_b = 4.2

features, labels = synthetic_data(true_w, true_b, 1000)features 中的每一行都包含一个二维数据样本, labels 中的每一行都包含一维标签值(一个标量)

features, labels

'''

(tensor([[ 1.3558, 0.6475],

[ 1.9661, -1.6909],

[ 0.4926, -0.7405],

...,

[-2.5782, -0.0687],

[-0.4201, 1.3112],

[ 0.3011, -0.4312]]),

tensor([[ 4.7190e+00],

[ 1.3868e+01],

[ 7.7023e+00],

...,

[-7.4886e-01],

[-1.1047e+00],

[ 6.2553e+00]]))

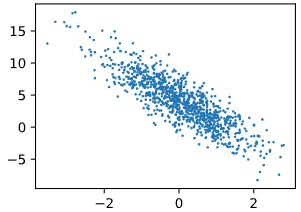

'''d2l.set_figsize()

d2l.plt.scatter(features[:, (1)].detach().numpy(), labels.detach().numpy(), 1);

读取数据集

定义一个 data_iter 函数,该函数接收批量大小、特征矩阵和标签向量作为输入,生成大小为 batch_size 的小批量

def data_iter(batch_size, features, labels):

num_examples = len(features)

indices = list(range(num_examples))

# 这些样本是随机读取的,没有特定的顺序

random.shuffle(indices)

for i in range(0, num_examples, batch_size):

batch_indices = torch.tensor(

indices[i: min(i + batch_size, num_examples)])

yield features[batch_indices], labels[batch_indices]

batch_size = 10

for X, y in data_iter(batch_size, features, labels):

print(X, '\n', y)

break

'''

tensor([[ 1.1817, 0.5027],

[-0.2387, -2.3561],

[ 0.6901, 0.2701],

[ 0.2277, 0.2214],

[ 0.5842, 1.1327],

[-0.2905, -0.3712],

[-0.8643, -1.2337],

[ 0.4548, 0.4493],

[-1.3668, 1.2860],

[ 0.4793, 1.9363]])

tensor([[ 4.8458],

[11.7319],

[ 4.6522],

[ 3.9097],

[ 1.5130],

[ 4.8722],

[ 6.6657],

[ 3.5533],

[-2.9160],

[-1.4316]])

'''初始化模型参数

在我们开始用小批量随机梯度下降优化我们的模型参数之前需要先有一些参数

w = torch.normal(0, 0.01, size=(2,1), requires_grad=True)

b = torch.zeros(1, requires_grad=True)定义模型

定义模型,将模型的输入和参数同模型的输出关联起来

def linreg(X, w, b):

"""线性回归模型"""

return torch.matmul(X, w) + b定义损失函数

def squared_loss(y_hat, y):

"""均方损失"""

return (y_hat - y.reshape(y_hat.shape)) ** 2 / 2定义优化算法

def sgd(params, lr, batch_size):

"""小批量随机梯度下降"""

with torch.no_grad():

for param in params:

param -= lr * param.grad / batch_size

param.grad.zero_()训练

lr = 0.03

num_epochs = 3

net = linreg

loss = squared_loss

for epoch in range(num_epochs):

for X, y in data_iter(batch_size, features, labels):

l = loss(net(X, w, b), y) # X 和 y 的小批量损失

# 因为 l 形状是 (batch_size,1),而不是一个标量

# l 中的所有元素被加到一起,并以此计算关于 [w,b] 的梯度

l.sum().backward()

sgd([w, b], lr, batch_size) # 使用参数的梯度更新参数

with torch.no_grad():

train_l = loss(net(features, w, b), labels)

print(f'epoch {epoch + 1}, loss {float(train_l.mean()):f}')

"""

epoch 1, loss 0.050854

epoch 2, loss 0.000226

epoch 3, loss 0.000051

"""比较真实参数和通过训练学到的参数来评估训练的成功程度

print(f'w 的估计误差: {true_w - w.reshape(true_w.shape)}')

print(f'b 的估计误差: {true_b - b}')

"""

w 的估计误差: tensor([ 0.0009, -0.0011], grad_fn=<SubBackward0>)

b 的估计误差: tensor([0.0007], grad_fn=<RsubBackward1>)

"""