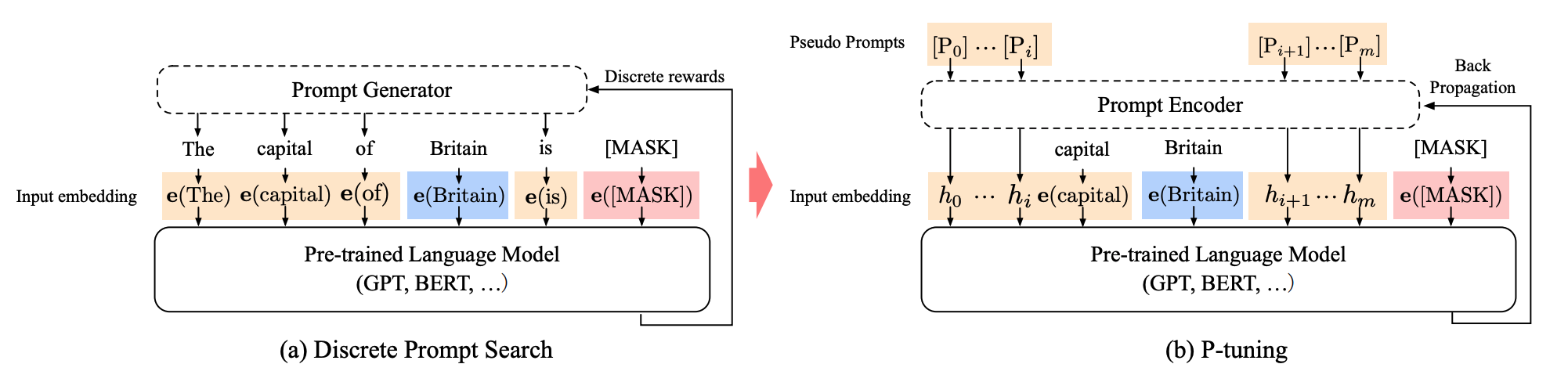

P—Tuning 是为了解决 NLU 任务而设计的 Soft prompts 方法,P-tuning 添加了一个可训练的嵌入张量,这个张量可以被优化以找到更好的提示,并且它使用一个提示编码器(例如 BiLSTM+MLP)来优化提示参数

技术解读

P-tuning 有两个版本,P-tuning v1(2021 年)和 P-tuning v2(2023 年)。P-tuning v1 通过使用一个 prompt encoder(例如 BiLSTM+MLP)来优化 prompt 参数,但这种方法在一些复杂的自然语言理解(NLU)任务上效果不佳,且只在较大的模型规模上表现良好

为了解决这些问题,P-tuning v2 被提出。P-tuning v2 在 v1 的基础上进行了改进,它不仅在输入层,而且在模型的每一层都加入了可训练的连续提示,这样可以更好地适应各种任务,包括复杂的 NLU 任务。P-tuning v2 通过多任务学习策略和深度提示编码器来优化提示参数,使得它在不同规模的模型上都能取得与全参数微调相媲美的性能

直观解释

P-Tuning 最大的特点是将通过引入 BiLSTM/MLP 的方法,使得模型可以更好的完成 NLU 任务。这种方法的优势在于可以在不改变模型结构的情况下,为 decoder 架构的模型提供 encoder 架构的特性